Das chinesische Technologieunternehmen Alibaba hat Qwen3-Omni veröffentlicht. Es ist ein neues generatives KI-Modell, das eine Kombination aus Text, Bildern, Audio und Video verarbeiten kann. Das Modell zeichnet sich durch seine „omni-modalen“ Fähigkeiten und seine Open-Source-Lizenz aus. Damit positioniert es sich als direkter Konkurrent zu proprietären Modellen von US-Technologiekonzernen wie OpenAI und Google.

Nach von Alibaba veröffentlichten Informationen ist Qwen3-Omni als durchgängiges System konzipiert. Es kann Eingaben aus allen vier Modalitäten annehmen und Antworten sowohl in Textform als auch in natürlich klingender Sprache erzeugen. Das unterscheidet es von vielen bestehenden Modellen. Googles Gemini 2.5 Pro kann beispielsweise ebenfalls Videos analysieren, ist aber ein Closed-Source-Produkt. Googles Open-Source-Modell Gemma 3n akzeptiert ähnliche Eingaben, kann aber nur Text ausgeben.

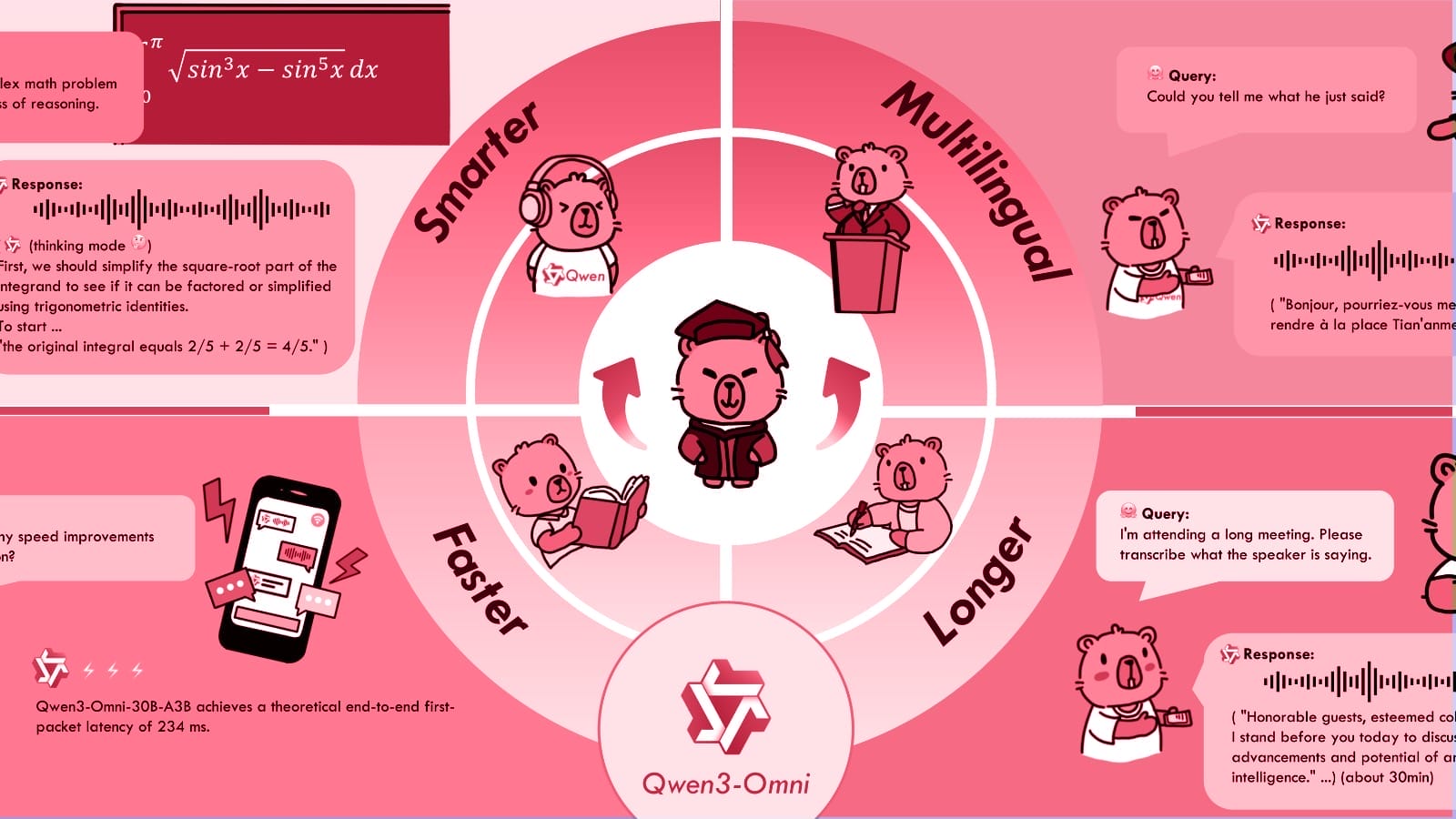

Alibaba gibt an, dass die Leistung von Qwen3-Omni bei 22 von 36 Branchen-Benchmarks für Audio und Video auf dem neuesten Stand der Technik ist. Gleichzeitig soll die Leistung bei Text- und Bildaufgaben nicht beeinträchtigt werden. Das Modell unterstützt 119 Sprachen für die Texteingabe, 19 für die Spracheingabe und 10 für die Sprachausgabe.

Architektur und Modellversionen

Das Modell basiert auf einer von Alibaba als „Thinker-Talker“-Architektur bezeichneten Struktur. Eine „Thinker“-Komponente, die für mehr Effizienz auf einem Mixture-of-Experts (MoE) Design basiert, ist für das Verständnis der multimodalen Eingaben und für Reasoning-Aufgaben zuständig. Eine separate „Talker“-Komponente erzeugt dann die Sprachausgabe. Das Unternehmen behauptet, dieses Design ermögliche Streaming-Antworten in Echtzeit mit geringer Latenz.

Alibaba hat drei Versionen des Modells veröffentlicht, um unterschiedliche Anforderungen zu erfüllen:

- Qwen3-Omni-Instruct: Die umfassendste Version, die sowohl den Thinker als auch den Talker enthält, um alle unterstützten Eingaben zu verarbeiten und sowohl Text als auch Audio auszugeben.

- Qwen3-Omni-Thinking: Eine Version, die sich auf Reasoning und Analyse konzentriert. Sie akzeptiert alle Eingabetypen, erzeugt aber nur Text. Das macht sie ideal für Aufgaben, die detaillierte schriftliche Erklärungen erfordern.

- Qwen3-Omni-Captioner: Ein spezialisiertes, feinabgestimmtes Modell, das sehr detaillierte und genaue Textbeschreibungen von Audio-Eingaben erstellt.

Lizenzierung und Verfügbarkeit

Qwen3-Omni ist unter der Apache 2.0-Lizenz verfügbar. Diese freizügige Open-Source-Lizenz erlaubt es Entwicklern und Unternehmen, das Modell kostenlos herunterzuladen, zu verändern und zu nutzen, auch für kommerzielle Anwendungen. Dieser Ansatz steht im Gegensatz zu den Closed-Source-Modellen von Konkurrenten wie GPT-4o von OpenAI, auf die nur über eine API zugegriffen werden kann.

Das Modell steht auf Plattformen wie Hugging Face und GitHub zum Download bereit. Alibaba bietet auch Zugang über seine DashScope API an, bei der die Nutzung nach Tokens abgerechnet wird. Laut Preisinformationen, die von VentureBeat berichtet wurden, variieren die Kosten für die API je nach Eingabetyp, wobei Video und Audio teurer sind als Text. Die reine Textausgabe kostet etwa 0,96 US-Dollar pro Million Tokens, während die kombinierte Text- und Audioausgabe mit etwa 8,76 US-Dollar pro Million Tokens für den Audioteil berechnet wird.

Anwendungsfälle und Systemanforderungen

Das Unternehmen hebt eine breite Palette potenzieller Anwendungen hervor. Diese reichen von Spracherkennung und -übersetzung über die Analyse von Musik und die Beschreibung von Videoinhalten bis hin zu interaktiven audiovisuellen Dialogen. Das Verhalten des Systems lässt sich über System-Prompts anpassen. So können Entwickler es für bestimmte Rollen adaptieren wie etwa einen Kundenservice-Assistenten.

Der lokale Betrieb des Modells erfordert erhebliche Rechenressourcen. Aus der Dokumentation von Alibaba geht hervor, dass das Basismodell „Instruct“ fast 80 GB GPU-Speicher benötigt, um ein 15-sekündiges Video zu verarbeiten, wobei der Speicherbedarf mit der Videolänge steigt. Um die Nutzung zu erleichtern, stellt das Unternehmen vorkonfigurierte Docker-Images bereit und empfiehlt den Einsatz von Inferenz-Optimierungsbibliotheken wie vLLM für eine bessere Leistung.