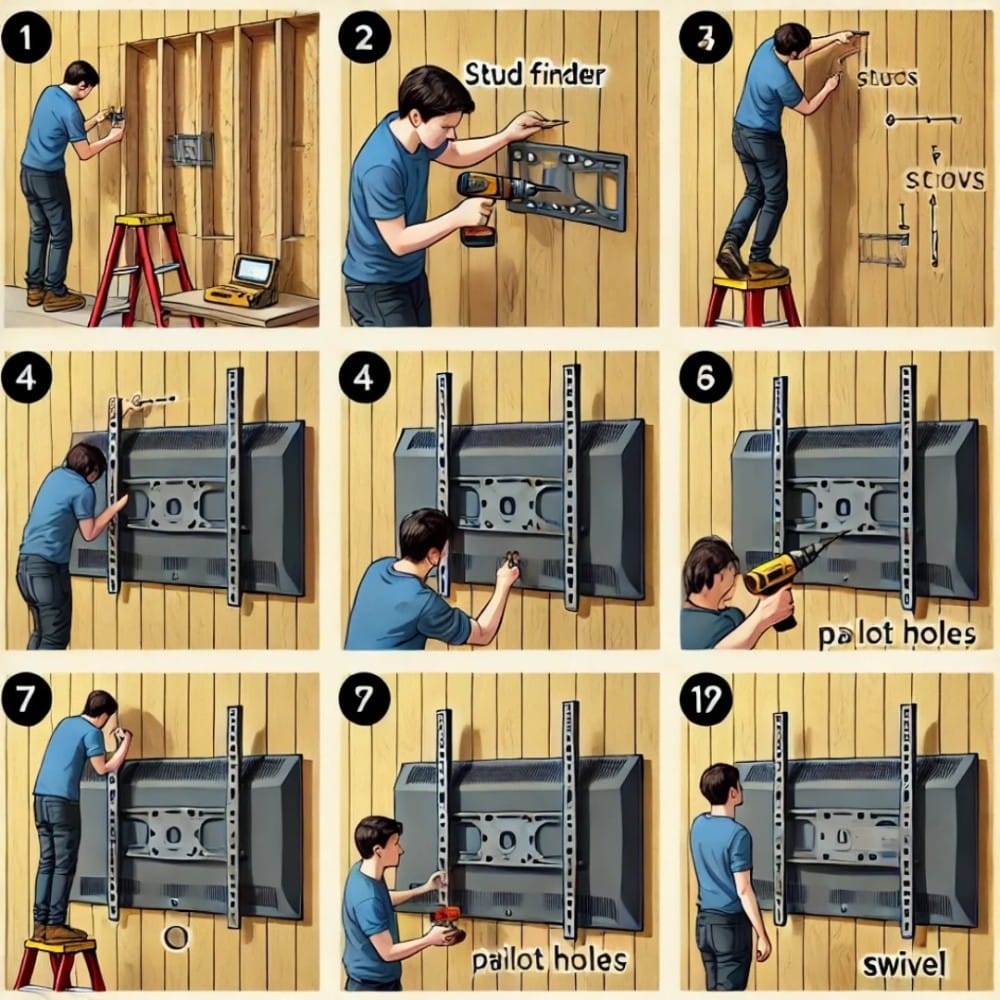

In einem früheren Smart Content Report zeigte ich eine kuriose bebilderte Anleitung, generiert von ChatGPTs Dall-E:

Ich finde solche „Fails“ spannend zu sehen, weil sich dort oftmals grundsätzliche Probleme zeigen.

Wir sind z.B. immer noch ein gutes Stück von einer KI entfernt, die die Welt um sich herum tatsächlich versteht („General World Model“). Im Moment imitieren diese Tools ihr Zielmedium so gut sie können, ohne auch nur ansatzweise zu wissen, was sie dort eigentlich produzieren. Das gilt für alle Medienarten: Text, Foto, Video, Audio.

Deshalb sind bspw. die Zahlen so unsinnig in der Grafik: Der Bildgenerator weiß nicht, was Zahlen sind, wie sie funktionieren und welche Rolle sie bei einer solchen Anleitung spielen. Er hat lediglich aus etlichen Beispielen gelernt, dass dieses Element dort auftaucht.

Und dann natürlich das grundsätzliche Problem mit der Anleitung im Bild: Offenbar gibt es viele Illustrationen, die zeigen, wie man die Rückseite des Fernsehers an der Halterung befestigt. Und das vermischt sich dann mit dem Rest des Vorgangs.

Wie gesagt: Weil die KI eben nicht tiefergehend versteht, was sie dort erzeugt.

Oder frage ChatGPT doch einmal, wie häufig der Buchstabe R im Wort Strawberry vorkommt. Du wirst sehr wahrscheinlich eine falsche Antwort bekommen. Warum? Weil ChatGPT nicht das Wort Strawberry sieht und auch keine Buchstaben. Es arbeitet intern mit Token und das können einzelne oder mehrere Zeichen sein. ChatGPT hat gelernt, wie diese Token zusammenhängen und kann mit diesem Wissen verblüffende Dinge bewerkstelligen. Aber es versteht eben nicht, was es liest oder schreibt. Siehe dazu auch diesen Artikel bei TechCrunch.

Daraus entsteht ein Kontrast, den ich persönlich immer wieder verblüffend finde. Denn auf den ersten Blick sieht die illustrierte Anleitung oben beispielsweise gut aus. Der Stil ist vertraut, die menschliche Figur sieht einigermaßen korrekt aus, es ist optisch ansprechend … Aber je länger man schaut, desto mehr Probleme entdeckt man.

Und genau so ist es, mit der heutigen Generation der KI-Tools zu arbeiten. Sie können viele Dinge gut. Sie können hilfreich sein. Aber man muss immer wachsam bleiben. Und man muss lernen, wo und wann sie scheitern.

Die Grenze zwischen dem, was die KI kann und nicht kann, ist bei alldem nicht geradlinig. Sie entspricht eher einem wilden Zickzackmuster. Wiederkehrende Schwächen zeichnen sich trotzdem ab, wenn man die Tools lange genug nutzt.

Es zeigt sich vor allem eines: Bei der überwiegenden Zahl der Aufgaben sind sie noch immer weit davon entfernt, einen Menschen direkt zu ersetzen.